质疑美国芯片Etched:AI领域最大赌注的尽头是散热?

原创 亲爱的数据 亲爱的数据

图文原创:亲爱的数据

图文原创:亲爱的数据Etched公司,

造AI芯片的美国创业公司,

1.2亿美金躺在银行账户,

公司创始人中有两位是哈佛辍学00后。

暂不列出投资人的豪华阵容,

以免把话题带歪了。

只要是英伟达的挑战者,

都值得高看两眼。

不能再多了。

除了英伟达的GPU,

还有,

AMD’s accelerators

SambaNova’s SN Series

Cerebras’s CS-2

Graphcore’s IPUs

Groq’s GroqNode

Tenstorrent’s Grayskull

D-Matrix’s Corsair

寒武纪的思元

英特尔的Gaudi

以上排名,

不分先后。

芯片在科技领域至高无上,

算法和软件再牛,

也得紧随芯片。

一旦有一种比肩英伟达的新的芯片问世,

大家争先恐后探索如何用好新硬件。

好消息是,

AI芯片足够重要,

看热闹,

谁会嫌事大呢

坏消息是,

吃瓜AI芯片,

门槛很高。

简直要通过一场考试:

《美国硅谷AI芯片考试题》

一言不合,

开始答题。

开卷测试

(一)

(一)基础知识(送分题)

1.Llama70B是什么意思?

Llama70B模型,

开源,且参数规模很大,

700亿,

由Meta公司开源。

2.求解模型权重所占存储空间?

Llama70B模型,

700亿参数,

700亿参数 × 每个参数2字节

= 140 GB 的模型权重。

(采用16位浮点数存储,BFloat16)

3.词元(Token)和中文字如何换算?

考虑不同的编码方式,

平均而言,

一个中文字大约对应0.7到1.5个词元。

4.请问大语言模型推理分成哪两个阶段?

第一个阶段准备(Prefill),

第二个阶段生成(Decoding)。

5.接上题,两阶段分别面对什么样的瓶颈?

准备阶段面对算力瓶颈,

生成阶段面对内存瓶颈。

6. 接上题,内存瓶颈为什么发生?

生成阶段引入了一个神奇的技术,

KV缓存(KV Cache)技术。

就是用额外的存储量,

换取了计算量的减少,

也就是将之前的计算结果存储起来,

后面直接用,不再重复算,

除了模型权重,KV Cache持续增加,

导致内存占用压力。

生成阶段,

当批处理量很大了,

KV缓存的持续增加,

导致了内存访问耗时的增加。

于是就有了内存瓶颈(Memory Bound)。

(二)

阅读理解题(送命题)

题目已知信息,

均为Etched团队声称,

或原话引用。

信息来源于公司官网,

或外媒采访。

电视采访上,Etched的CEO说:

“We're building a reticle sized die.

So a very big chip that is acomplicated”

请问Etched公司的Sohu芯片面积大约是多少?

解答:

Reticle Sized Die是光罩孔极限尺寸。

光罩孔极限尺寸大约826mm⊃2;的尺寸。

一般,800 mm⊃2;以上的芯片被称为大芯片。

于是,

CEO说Sohu芯片很大,very big chip。

看懂这句,

英语都给满分。

可惜,这次考AI芯片知识。

再看英伟达H100芯片,

尺寸是814mm⊃2;,

也很大,

采用台积电4纳米工艺。

也就是说,

Sohu芯片和H100芯片面积差不多。

这个结论,留后备用。

Sohu芯片也采用4纳米工艺,

当然也得去台积电,

这也麻烦,

得拎出来单聊。

为什么?

台积电2023年的营收为706亿美元。

即使这家公司的1.2亿美元全部流向台积电,

也只占台积电营收的0.17%。

有限的产能,

为什么要优先考虑这位00后CEO的订单,

而不是现有客户呢?

台积电的两大客户,

苹果和英伟达,

哪个不宝贝。

如果没有记错的话,

台积电所有2024年第四季度和2025年第一季度、

第二季度、第三季度的生产工厂运行计划都已全部预订并付款。

到此,谭老师我不得不感慨一句,

台积电是不可替代的先进制程代工龙头,

没有之一。

提起台积电,

谭老师我就心口疼。

算了,

不说了,

做题。

(三)

计算题(超纲题)

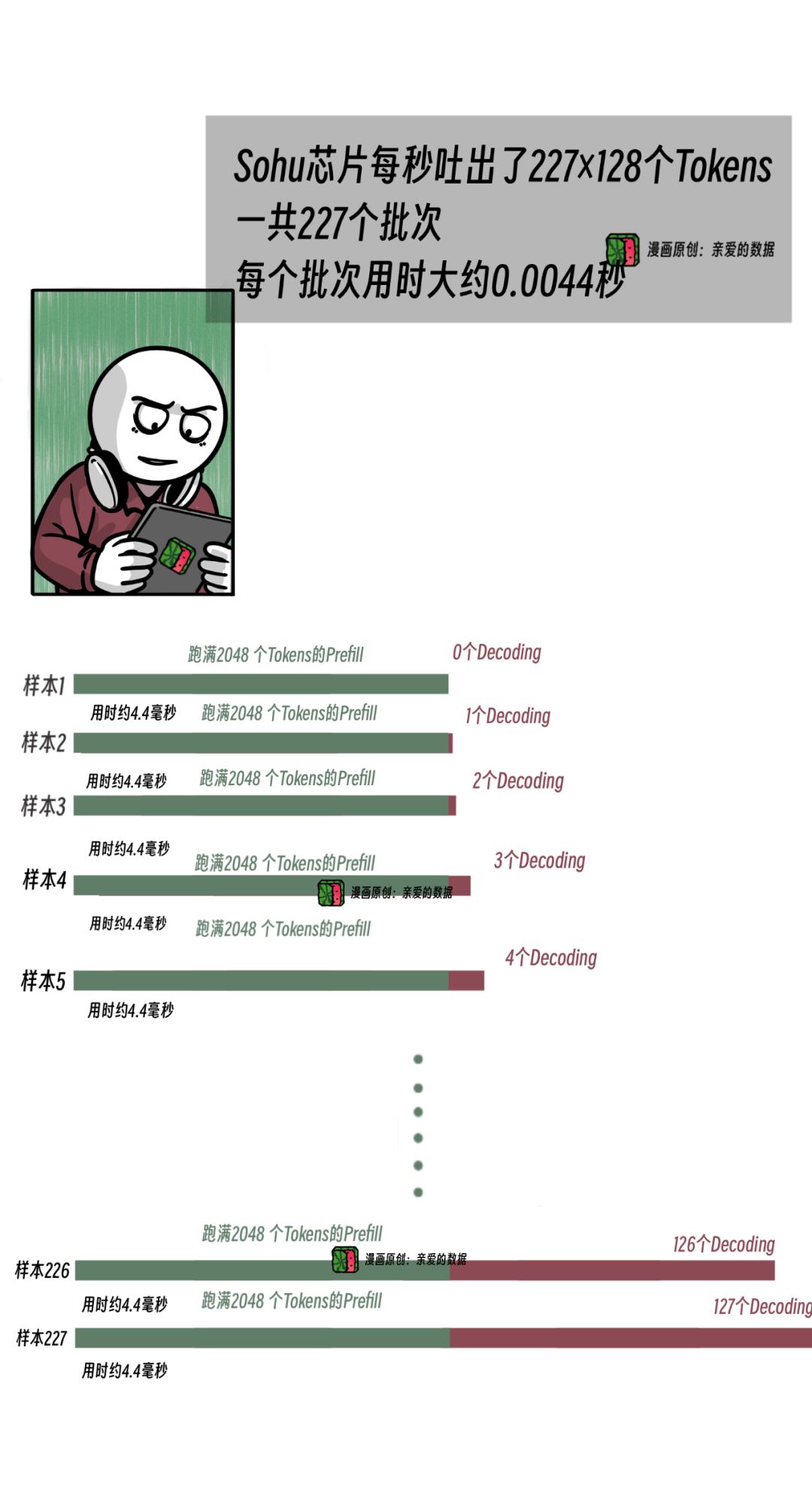

每秒处理词元的数量是50万个词元。

速度简直飞起无影,

看一次,

惊一次。

后面推算一下,

就不一样了,

更惊。

已知:

一台8xSohu服务器,

跑Llama70B模型,

每秒可处理50万个词元。

求解Sohu芯片单卡算力为多少?

并分析达到这个算力的难点。

解答:

1.求解一个批次参与计算的词元总数量?

既然输入2048个词元和输出128个词元,

那么,2048 + 127=2175(个)词元。

就是说,

Sohu芯片做了一个序列长度为2175个词元的运算。

2.计算Llama70B模型所需算力?

套用公式,

大模型所需算力=参数量x序列长度x 2

数字2代表着一个数要做乘加,所以算两次。

(2048 + 127) 个词元 × 700亿参数 × 2

= 304 TFLOPS。

就是说,这个模型需要的算力是304TFLOPS。

接着算,

用每秒处理50万词元除以(2048 + 127),

得到批次数227。

500000 ÷(2048 + 127)=227(个)批次

注意,这些批次都是在一秒内完成的。

于是,每个批次用时0.0044秒,

于是,每个批次用时0.0044秒,也就是4.4毫秒。

这是个眨眼都不够的时间。

然而,对于当今顶尖AI芯片来说,

足够完成一次复杂的计算任务,

电光石火、流星飞电,

这些古老的成语,

完全无法形容AI芯片的计算能力。

如若成真,

谭老师我击节赞叹,连拍大腿。

总述一遍,

上面的计算在描述这样一件事,

在这短短的4.4毫秒里,

AI芯片的计算性能高达304TFLOPS。

那么,1秒的计算性能是多少呢?

再拿304 TFLOPS除以0.0044秒,

约等于70000 TFLOPS。

也就是说,

只要Sohu芯片的系统,

抗下如此高强度运算,

性能得到达70000 TFLOPS。

放眼全球,

用一战封神来形容,

都毫不吹捧。

最后一步,

又因为Etched声称是8卡,

系统性能需要再除以8。

70000÷8=8750(TFLOPS)

答案是:Sohu的单卡性能是8750TFLOPS。

----------------------------------------------

答题心得:

题难又如何,

考试而已,

难的是人生。

数学题不会就是不会。

大不了辛苦一下,

把答案抄上。

这个数字,

美国专家看了也瞳孔地震。

不过,吃瓜群众可能听了这个数,

似有如无,没啥感觉。

那我不得不点评一番了。

3.分析实现这个算力的难点:

据以上推算,

再代入第一道“阅读理解题”的结论,

“Sohu芯片和H100芯片面积差不多”。

Sohu芯片单卡性能8750TFLOPS,

而H100的计算性能1000TFLOPS,

用过H100的都知道,

H100芯片的时候,

性能达到300或者400TFLOPS就挺高了,

30%到40%的利用率。

然而,英伟达公司H100芯片开始,

引入了液冷散热,

再说细一点,

H100是有两个版本的,

700TFLOPS的版本,风冷。

1000TFLOPS的版本,液冷。

无独有偶,

英伟达更是从B100开始,

将风冷全部转为液冷。

Sohu芯片算力翻了20倍,

那对散热的需求更不用说了,

Sohu芯片和英伟达H100同样面积,

那岂不是同样面积的散热也得翻20倍。

这个能力,

别说定制,

我严重怀疑,

地球上没有这样的散热供应商。

补充下,

1PFLOPS是H100理论最高值,

一般用到400-500TFLOPS左右。

Sohu这个是使用性能8750TFLOPS,

实际设计更高。

---------------

---------------答题心得:

谭老师我只能说,

文章标题里的那句话,

Sohu芯片并非挑战计算极限,

而是散热极限。

有些热情媒体把Etched捧为地表最强芯片。

我只能同意一部分,

地表散热最强。

别忘了,

现在都还在聊仿真层面的设想。

有人忍不住要喊,

PPT造芯了,

克制一下,

人家没有流片,

也融了1.2亿美金。

了不起的“美国梦”,

盖茨比来了也得点赞。

Sohu芯片的故事是,

英伟达公司只用3%的晶体管用来做计算,

这个思路不是做AI芯片最好的思路,

完全有理由堆得更多,

堆出个20倍提高。

这种思路才是最好的。

用这种思路,

再配合Transformer模型专用集成电路(ASIC)。

他们不用针对谁,

在座的各位都成了垃圾。

表面上看,都被秒成渣。

于是,市面上,

有些媒体炒作,

标题为,

《推理性能已超B200十倍,超H100二十倍》,

难道只要有个新产品出来,

都要一顿崇拜,一顿夸吗?

规律常常是,

不论谁猛吹超越英伟达,

客户依然冷静地选择英伟达。

最后,

灵魂一问,

超10倍,20倍,

散热到底怎么解决?

这么非主流的试卷。

先发个朋友圈让他们眼红一下。

One More Thing

看懂Etched公司 AI芯片,

需要几个冷知识。

1

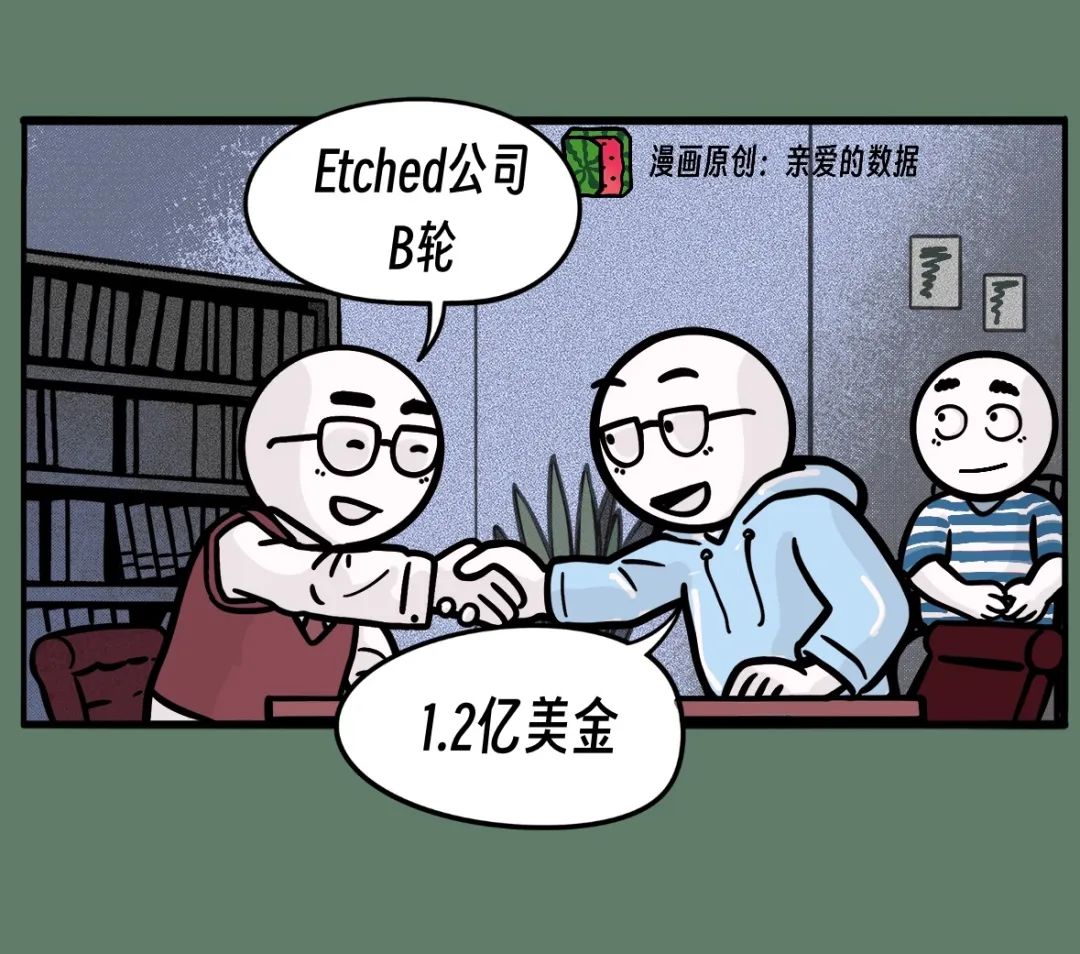

冷知识一:专用芯片

通用芯片就像一把瑞士军刀,

完成各种各样的任务

(比如,CNN、LSTM、Mamba等模型)。

专用集成电路就像一把手术刀,

Etched AI芯片唯一的“手术”任务,

就是Transformer模型,

设计思路是把Transformer模型“硬化”在芯片上。

也就是,针对性地设计与Transformer模型相对应的硬件架构,

性能做强一个数量级。

不过,Transformer虽强,

但其他模型都不能用这颗芯片。

如果Transformer消失了,他们就会死。

因为与市场上其他公司不同,

他们的芯片只支持Transformer模型。

如果赌对了,他们的芯片将成为市场上性能最强劲的芯片,

领先其他芯片一个数量级。

正如,Etched创始人兼CEO,

在接受"Bloomberg Technology"电视采访时说:

“我们正在人工智能领域下最大的赌注。”

2

冷知识二:AI芯片的性能指标。

TeraFLOPS一个衡量计算机的计算能力的指标,

是每秒浮点运算次数的单位,

例如,如果一台计算机在一秒内能进行1万亿次浮点运算,

那么它的TFLOPS值为1。

而目前市面上主流的国内外GPU芯片算力是多少呢?

以英伟达A100为例,

A100的性能是312TFLOPS是什么意思?

这里可以拆分成两个部分来理解。

浮点运算次数(FLOPS);

Tera,计量单位,代表(10^{12})(一万亿);

所以,312TFLOPS是代表,

一块GPU每秒能够进行312万亿次浮点计算。

除此之外,从小到大的排序是GFLOPS、TFLOPS、PFLOPS、EFLOPS,

分别代表每秒能够执行10^{9}、10^{12}、10^{15}、10^{18}次浮点计算,

桌面级通用芯片,是10到100GFLOPS。

有件真事,

我听图灵奖获得者杰克·唐加拉(JackDongarra)教授说,

他家住在美国田纳西州的橡树岭,

距离他家大约15公里的地方,

有台计算机,

峰值性能是2EFLOPS。

注意,数字后面跟的是大写字母E。

很高的那档。

这台计算机名叫Frontier(前沿),

是世界上速度最快的超级计算机,

这就是存世最高的那档FLOPS,E级机。

回到我们在日常生活中接触到的物理量,

往往非常巨大,

或非常微小。

为了避免麻烦,

我们使用计量单位来将这些巨大的或微小的物理量,

缩放到一个合适的范围内。

例如,可用千米来表示地球的半径。

用纳米来表示原子的直径。

所以,用TFLOPS表示计算机性能,

也是如此。

《我看见了风暴:人工智能基建革命》,

《我看见了风暴:人工智能基建革命》,作者:谭婧