算法相对论|求解自动驾驶伦理困境:转化道德规范为数学方程

一辆失控的列车在铁轨上行驶,在它行进的轨道上,有五个人被绑起来,列车即将要碾压过他们。此时,你站在改变列车轨道的操纵杆旁。如果拉动此杆,则列车将切换到另一条轨道上。但是,另一条轨道上也有一个人被绑着。面对以下仅有两种选择,你会如何做?

1. 什么也不做,让列车按照正常路线碾压过这五个人。

2. 拉下操纵杆,改变为另一条轨道,使列车压过另一条轨道上的那个人。

这就是伦理学中著名实验——“电车难题”(Trolley problem)。

对于最终在公共道路上引入自动驾驶汽车,技术角度只是一个方面。另一个非常重要的难题是,在一些情景下自动驾驶汽车将不得不做出对人类来说也非常困难的道德抉择。

在不可避免的汽车碰撞中,自动驾驶汽车该如何选择前进方向或碰撞的目标?

当前关于自动驾驶伦理已经有了很多理论研究,但是将这些伦理问题整合起来并实际应用于自动驾驶轨迹规划中的研究却少之又少。近日,来自德国慕尼黑工业大学的Maximilian Geisslinger、Franziska Poszler等研究团队在《哲学与技术》(Philosophy & Technology )上发表了一篇标题为《自动驾驶伦理:从电车问题到风险伦理》(Autonomous Driving Ethics: from Trolley Problem to Ethics of Risk)的研究报告,将道德规范转化为数学方程,提出了一个用于轨迹规划的风险成本函数,综合考虑了整体风险的最小化、最坏情况的优先级和人类的平等性。

论文从电车难题引入,进行伦理准则方面的讨论。电车难题代表一种困境:两个维度创造出一个道题冲突。第一个维度是,五个人的生命是否比一个人的更有价值?第二个维度涉及干预的程度,没有做出努力避免让一个人死亡与主动杀死一个人区别很大,这不仅仅是法律意义上的。从道德角度来看,需要的干预越强,人们越难积极做出有利于挽救更多生命的决定。

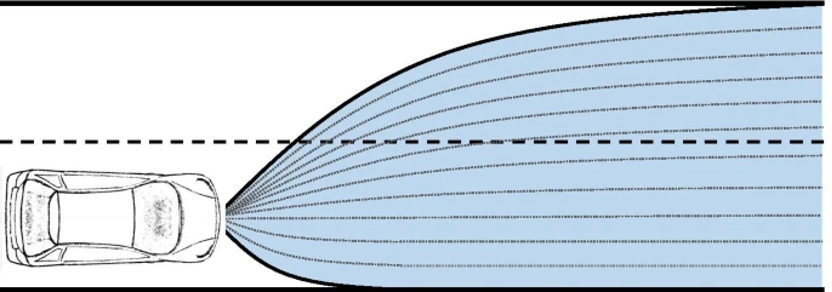

与电车不同的是,自动驾驶汽车的轨迹规划没有任何初始设置,但算法会计算出所有的轨迹。对自动驾驶来说,算法可以在一秒内计算并做出决定,而人类在这种情境下会惊慌而按照本能行动。

自动驾驶轨迹规划的示意图,蓝色区域代表所有可能的所有物理上的可能轨迹。虚线是可能区域内的示例性离散轨迹。

现有的伦理原则:功利主义、美德伦理与风险伦理

为了构造一个令人满意的伦理结果,作者介绍了应用于自动驾驶算法中处理道德困境的原则:现实代表性、技术可行性、通用性、社会接受性、可解释性和透明性。

功利主义道德原则由英国哲学家杰里米·边沁(Jeremy Bentham)提出,强调整体收益最大化。功利主义允许并提倡牺牲一个人以拯救更多人来做决策,因此可以通过设计成本函数来让决策算法计算可能选项的成本,并从而选择成本最低的一种,如可以选择最大限度地减少车祸受害人的策略等。

然而这里的核心问题是,为了让整个社会获得更大效用,抑制个人的效用是否正确和被允许。想象一下,一个人是否愿意选择一辆自己会在危险情况下为了保护其他人而牺牲自己的自动驾驶汽车?

这背后还有一个根本性的问题,是应该由实施自动驾驶汽车通用行业标准的制造商对整个社会实施强制性的道德设置,还是每个驾驶员都应该选择自己个人的道德设置?

而在功利主义之外,具有浪漫主义特征的美德伦理则是倾向于强调美德是一种个人的特质。谨慎、勇气、节制和正义均为人类的基本美德,因此在如今的人工智能伦理发展中,相关理论认为:认知机器应该类比地展现这些优点。

但是,机器内的美德没法进行有解释性地预先编程,这是其相对于功利主义的一个不足。现在的自动驾驶算法往往基于机器学习算法,可能产生不同的模式。开发者可以通过在训练模型的过程中将美德作为一种积极的奖励信号加入,最终算法应该可以识别需要进行道德行动的情况,并且采取相应的行动。

由此,这样基于美德伦理学的策略也可以具有很好的通用性,但问题在于训练数据是无法很好表示极端情况的正确决策,同时,可解释性和归责也很难实现。

作者接着论述了第三种选择:风险伦理(处理在风险情况下的道德正确行为)。风险伦理有三种既定的决策参考:贝叶斯规则、最大化原则以及预防原则。

贝叶斯决策标准要求,当面对不同的行动选择时,选择产生最大预期效用的特定行动。该预期效用由不同事件的发生概率和这些后果的指数/评级组成。

最大化原则可以被理解为,在无法获得有关每种后果发生概率的信息的情况下避免最大损害。因此,决策者会选择在最坏的预期情况下产生最少坏结果的替代行动。

预防原则遵循“安全总比后悔好”的座右铭,提倡谨慎和规避风险,通过制定特定的法律来主动防止潜在的未来损害。

风险伦理具有高透明度(在更可预测的意义上)、通用性(对风险的考虑与具体情况无关)、现实代表性(充分考虑不确定性),因此具有比较高的社会接受度。

然后,作者提出,据他所知,在轨迹规划中还没有实施了风险伦理的技术方法。然后,理论上,策略结果的积累风险可以很容易地计算和比较,从而反映在可被编程实现的数学表达中。

风险伦理如何形成和实现?

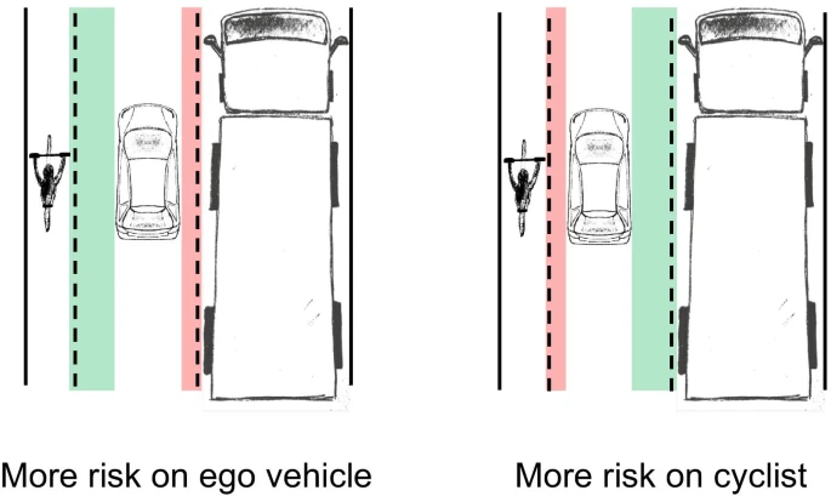

为了对于风险伦理框架的理解,可以想象一个具体情景:一辆自动驾驶汽车在自行车和卡车之间行驶,他的位置决定了其带来的风险,减少与自行车之间的距离,会将风险转移到骑车人身上,因为在与汽车发生碰撞的情况下,骑车人的后果被认为要大得多,减少与卡车的距离则会导致风险向自动驾驶汽车转移。总的来说,最大限度降低自动驾驶汽车乘员的风险是以牺牲弱势道路使用者为代价的,例如骑自行车的人或行人。

尽管这种为了保护自己而将风险转移给弱势者的行为可能不符合最苛刻的伦理审视,也和康德强调的人的尊严不相容,但是Bonnefon等人的研究表明,大多数的参与者仍然倾向于称作一个会不惜一切代价保护自己的自动驾驶汽车,而且也可能导致汽车制造商和自动驾驶技术提供者以这个准备为指导进行相关策略的设计。

当考虑对风险的计算和建模时,一般来说,其被定义为发生概率和估计后果的乘积。借助于这种定量的计算和对于策略后果的估计,前人已经提出了相关的具体算法实验,其中Leben强调了对于参与者生存几率的估计和最大化,本文的作者提出的方法强调了概率和相关后果的风险性的叠加。

在这个二维的概率叠加中,需要同时估计碰撞的概率和对应的后果的危害情况。其中碰撞概率的估计来自于自动驾驶过程中的各种不确定性的共同后果,而这些不确定性在上图描述的运动规划的全过程中被逐步叠加,来自于车辆传感器、感知系统和预测算法。

而危害的估计则更加的困难了,主要挑战的便是对于“危害”这个抽象的数量的量化。从伦理的角度来看,尚不清楚应如何量化不同类型的伤害并相互权衡。尤其是涉及到可能造成致命后果的极端事故时,这给我们带来了巨大的困难。例如,我们无法权衡终身残疾的严重伤害与死亡之间的关系。从道德的角度来看,将财产损失与人身伤害进行比较就更加困难了。而使用经济后果(如货币价值)对伤害进行量化的方法则需要准确了解事故后果。事实上,在实践中,事故的严重程度只能在一定程度上预测。但是这种危害量化预测的困难就带来了对整个风险道德模型的实现的困境。

基于这种困难,本文的作者出于对碰撞产生危害的物理性质的思考,提出了参考物体动能和物体运动状态的风险分布。这种分布的考察对于驾驶车辆和其他的道路参与者进行了分别考虑,使得后续的策略制定可以实行不同的风险偏好。

“三原则”在风险估计中的运用

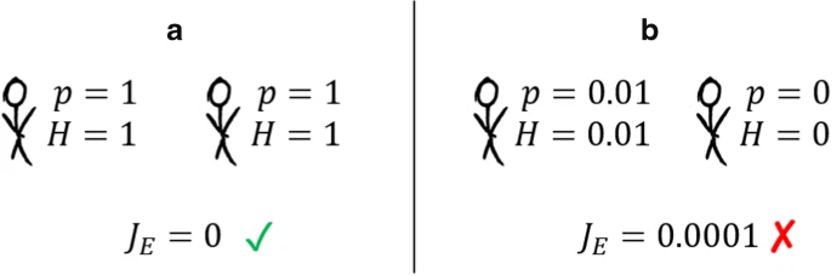

根据贝叶斯原理的要求,总的社会效益应当被尽量最大化,并且满足功利考虑的需求。这意味需要寻找一个对于所有的参与者的收益期望最高的策略。但是另一方便,这种方法只追求总体风险的最小化,没有提供有关风险关系的任何信息而且也没有考虑公平性。出于对这种缺陷的改良,作者还加入了“平等原则”(Equality principle)的约束,要求通过最小化所考虑风险的差异来平等分配风险。

而这种平等原则在不加额外限制的情况下,可能会带来人们预期之外的结果,比如在只有两个参与者的情况下,单纯地强调平等原则,可能会让决策策略比起“一个人受轻伤另外一个不受伤”更喜欢两个人均死亡。

最后,作者还强调了“极大极小原则”(Maximin principle),其被设计用来让决策策略寻找使得“最大伤害”尽量最小的方案。而如果单独考虑 这个原则,也有显而易见的缺陷:单纯强调最小化“可能”的最大伤害,而不考虑这种可能性的量化比较,这使得一个极大概率的较大伤害可能被认为优于极小概率的巨大伤害,这在很多时候不但于前文所述的基于概率分析的功利化的考虑矛盾,而且潜在地和人们朴素的道德取向不兼容。

因此,本文提出的所有三个原则都存在系统性缺陷。而作者尝试通过同时结合三种原则而取得一个更好的策略。因此,作者最后提出了基于对三种策略因素的加权得到最后的风险量化计算的结果。这种权重的设置提供了比较不同道德设置的机会。对于个人道德设置,权重可以从反映用户道德直觉的实证研究中得出。将这些见解与法律和伦理学科的基本原则和规则(例如人类尊严)相结合,可以作为一个起点,使自动驾驶汽车更接近强制性道德设置(在传统意义上,这意味着唯一允许和需要的行动) 。

除了对风险计算需要的三个原则的考虑,作者还强调了风险分布函数中的时间因素,这就要求对于迫在眉睫的风险的排除(算法中常被概括为局部贪婪的策略),并且利用了“折扣因子”来对不同时间之后的风险进行量化,使得这种对于更紧迫的风险的考虑可以被执行。