世界会客厅·跨年场|沈虹:被算法支配,值得恐惧吗

2020年12月31日,澎湃新闻推出了“世界会客厅”跨年特别场,五位青年学者齐聚上海市虹口区北外滩,探讨科技与人文的边界。刚刚过去的2020年,各种“黑天鹅”齐飞,新的一年,我们将如何与不确定性共处。

讲者沈虹是美国卡内基梅隆大学人机交互研究所的研究员,2020年,她开始在澎湃新闻更新一个名为“AI社会学”的专栏。

近些年,看似遥不可及的“算法”逐渐走下神坛,全面进入人们的日常生活。有时,我们是算法系统中的用户,有时,我们是它的“打工者”。被算法支配,值得恐惧吗?

以下为澎湃新闻(www.thepaper.cn)整理的发言摘录,以飨读者。

什么是算法?

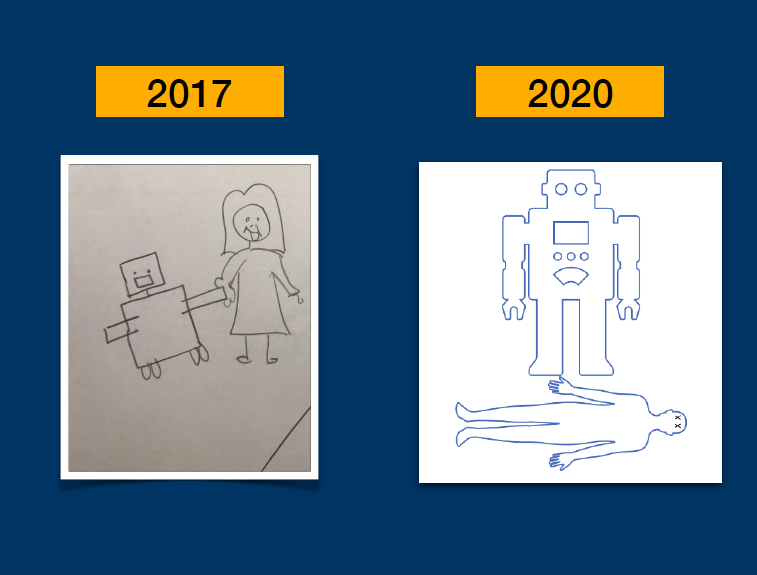

算法是什么?这是每年AI社会学这门课开课的第一个问题。每年我会发给学生一张白纸,让他们画出自己心目中的算法形象。今天我想和大家分享两组来自不同时期的答案。

第一组来自2017年,那时人工智能和算法的形象类似小说《银河系漫游指南》中那个人性化、甚至有些忧郁的机器人马文,或是一个小机器人拉着小女孩的手(下图左侧),齐心协力往前走。当时学生们心中的人工智能和算法还是非常美好的。

第二组来自2020年,算法被理解成一群人用计算机对另外一群人进行控制以及压迫。而在这一张(下图右侧)里,人工智能算法成了一个冷酷的机器人,踩在人类的尸体上,面无表情往前走。

不同时期,学生眼中的人工智能和算法。图片来源:沈虹

对照来看,不难发现一个非常明显的趋势,学生对人工智能算法的看法似乎变得越来越负面。不止学生,过去两年,美国对人工智能乃至整个科技行业的看法都在往下走。

这背后似乎有两个原因。一方面,近些年,原本“高大上”的人工智能算法全面渗透了每个人的日常生活,不仅仅是自动驾驶和面部识别这类所谓高科技企业,也是人们家门口的电表、路口的红绿灯,甚至是每天的工作日程、百度搜索和芝麻信用。人们在日常生活里与算法全面互动,体会着它们的威力,同时也体会着它们的不足。

另一个原因,随着科技企业权力范围的日渐扩大,全球内它们受到的质疑、引发的争议也愈演愈烈。比如,谷歌图片曾为非裔美国人打上了“大猩猩”的标签,亚马逊的招聘算法系统曾经系统性歧视女性应聘者,而微软的人工智能聊天机器人刚上线不到24小时,就被Twitter网友教成了种族歧视者,诸如此类,不胜枚举。

一些科技巨头逐渐成为美国国会听证会的常客,比如Facebook,以至于马克·扎克伯格不得不更改他在2010年的那句名言 “我们是科技公司,不是传媒公司,我们不对平台上的言论负责”,2020年他只能承认:“我们对用户在Facebook上分享的内容负有责任吗?我相信这个问题的答案是:是的。”

2019年,马克·扎克伯格出席一场听证会。图片来源:Getty

谷歌之前有句著名的企业座右铭“不作恶”(Don’t be evil),现在被各大媒体头条做成反问句,科技行业到底有多“邪恶”?

类似的质疑在国内也屡见不鲜。也许你刚和朋友聊完天,谈到想换一台新手机,电商在十分钟之内就会给你推荐一台最新的iPhone。无论科技企业是不是在监听你的对话,类似的网图、段子恰恰证明了公众对于这些企业巨大的不信任感。

同样,算法系统对外卖骑手的劳动压榨也在2020年刷屏。人们对被迫“996”的工作很难接受,因为说到底,人们发现我们都是在为算法系统打工的“打工人”。

当人们发现,算法不再是高高在上的科技桂冠,而是深深嵌入人们日常生活之后,我们就需要社会学的介入,这其实就是AI社会学的起点。

沈虹连线世界会客厅现场。澎湃新闻记者 朱伟辉 图

“打工人”或“用户”,你该如何理解算法?

我想用以下两本社会学和传播学的著作和大家探讨这个问题。

第一本是纽约大学媒体文化和传媒学院的副教授写的《设计成瘾》(Addiction by Design),它分析了“赌城”拉斯维加斯的老虎机是如何运作的。

第二本是微软研究院研究员玛丽·格雷(Mary L. Gray)写的《幽灵工作》(Ghost Work),她系统研究了硅谷是如何在全球范围内制造了一个“全球下层阶级”(global underclass)。

这两本书,一本讨论用户和算法的关系,另外一本讨论劳动和算法的关系。

《设计成瘾》封面。图片来源:Amazon

《设计成瘾》写于2012年,主要分析对象和我们今天所说的算法关系不是很大。作者通过人类学的方法,系统描述了拉斯维加斯的赌场业如何推动优化设计来提升用户体验,使顾客进入所谓的一种“机械”状态,制造“成瘾”症状,延长在机时间。

书中提出一个著名的概念叫做Ludic loop,指的是老虎机的设计者如何通过不定期、不定量、不可预测的给予奖励,使老虎机的使用者上瘾。如果要想使人们更容易上瘾,设计者只需要把用户的某种行为和不定期的奖励联系起来——在老虎机的语境里就是“拉动杠杆”,每一次拉动杠杆,要么能立即得到一份诱人的奖励,比如说大量的现金,要么什么也没有。这些奖励变化的几率越大,人们越容易上瘾。

作者还发现,和其他类型的赌博相比,人们对老虎机上瘾的速度快三到四倍,事实上,在美国,老虎机赚的钱比棒球、电影、主题公园所赚钱的总和还要多。

有趣的是,这样一本写赌场和老虎机的书,十分精确地描绘出了算法时代我们作为“用户”的状态。最明显的是我们和智能手机之间的关系,数据显示,在美国83%的“千禧一代”是和手机一起入睡的,90%的人早上起来第一件事是看手机。每三个人里就有一个会把手机带入厕所。平均每个人每天查看手机的次数多达150次。

我们真的需要看那么多次手机吗?现代智能手机的设计,尤其是社交媒体等于把老虎机装进1亿人的口袋里。当我们点击手机上红色的通知,想看看里面有什么内容,就等于在拉动老虎机的杠杆。当我们刷抖音、快手等无限滚动自动播放的应用程序时,也是在玩老虎机,这是视频网站常见的令人上瘾的设计技巧。

微信有“红点”(即“未读消息”的提示符)时,你是不是急于把它消掉,你是不是常常被碎片化的信息打断了工作节奏,是不是在删除社交软件之后又忍不住装回来了。

这两年,设计成瘾的负面影响力越来越为人所知。一份基于美国青少年的研究发现,由于手机的普及,青少年们不愿意出门,不愿意约会,不愿意工作,他们更愿意在家玩手机。与那些在社交媒体上花费时间较少的学生相比,每周在社交媒体耗时超过10个小时的学生,声称自己不快乐的比例高达56%,经常使用社交媒体的学生患抑郁症的风险增加27%,每天在电子设备上花费时间超过3个小时的青少年,自杀风险的可能性增加35%,女孩,尤其是遭受过打击的女孩儿出现抑郁症的症状要增加50%。

作为用户,我们应该怎样改变自己对算法的上瘾状态?谷歌的前任设计伦理学家Tristan Harris提出了以下三点,用来改变自己对算法的上瘾状态:

第一步,改变意识。首先,我们需要认识到,对算法的上瘾、对这些社交程序和智能手机的上瘾,其实并不是个人缺乏控制力,而是科技产品的设计导致的上瘾。社会学们家常说,谁从中获取最大的利益,谁就应该承担利益带来的风险;同样,谁在制造风险,谁就应该对风险造成的结果承担责任。所以,科技企业们应该对“上瘾经济”承担最主要的责任,而不是用户。

第二步,改变设计,如何改变智能手机和社交媒体的设计?早上醒来,我们通常会打开微信、微博、抖音、小红书,每一个应用程序刷一遍,这一刻,每一个应用程序都在争取我们的注意力,打断我们的工作节奏。试想,可否在手机上设计“分区线”——将早晨和晚上的应用程序分开,早上只显示与工作和日间活动有关的程序,晚上只显示与休闲娱乐有关的程序。

2018年,苹果和谷歌分别推出针对iOS和安卓操作系统的时间管理服务,前者有所谓的屏幕使用时间功能,后者则有digital well-being功能,这两个功能都试图为用户提供时间管理。

第三步,变革商业模式和责任制度。Tristan指出,科技公司很大一部分收入就是广告收入,其设计法则是尽可能使用户更久地停留在平台上,用户会更多地点击广告、花费更多的钱购买商品……这直接导致了上瘾模式的产生。

只有从根本上改变以上商业模式,即科技企业不再依赖广告收入,才有可能从根本上改变上瘾式的设计。

《幽灵工作》书封。图片来源:Amazon

第二本书是微软的高级研究员Mary Grey写的《幽灵工作》,她用了人类学方法,详细描述了人工智能背后的人工劳动。需要注意一个很重要的事实,整个AI产业和科研,从一开始就是建立在庞大的人类劳动的基础之上。计算机视觉的经典数据集“ImageNet”就是由五万多名来自世界各地的众包工人,在亚马逊的众包平台上进行手动标注的。

人工智能时代,人往往纠结于我的工作会不会被AI取代,但又忽略了一点,现代AI仍然寄生在庞大的人类劳动之上,是用无数血肉之躯的人类劳动养育了今天的人工智能。

同时,作者也指出,人工智能将永远面临“最后一英里困境”(Parodox of automation’s last mile),再发达的算法,都需要人类劳动进行实时调控。

2019年,《纽约时报》调查了谷歌旗下一项AI订餐服务,10次试验中4次成功,但其中只有1次是通过AI进行的,其余3次都是外包的真人服务。即使在自然语言处理飞速发展的今天,AI订餐服务仍然需要大量的人工,比如一位来自印度的众包工人,很可能就在为谷歌的AI订餐服务进行人工操作。而在中国的语境下,自动化的最后一英里可能是把热气腾腾的外卖送到你手上的外卖小哥。

此外还有“AI清洁工”,广泛存在于各种社交媒体和内容分发平台之后,其中很重要的一类是所谓的内容审核员,他们处理平台上那些少儿不宜和暴露的内容。社交媒体巨头脸书就曾大量雇佣外部公司员工进行内容审核,这些“临时工”全职工作8小时,每人每天处理近8000则信息,其中包含大量暴力不适的图片。因为目前的AI识别远未达到自动处理人类纷纭复杂、千变万化的信息的能力,比如,人工智能如何判断一张图片的裸露部分到底是艺术品还是色情照片?

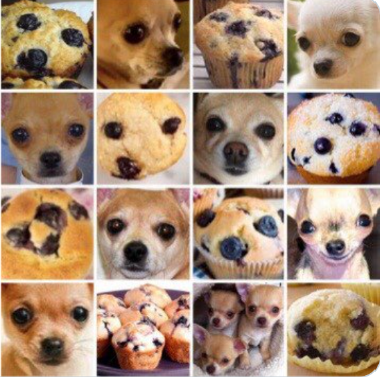

AI可以分辨哪张图是吉娃娃,哪张是蓝莓麦芬吗?图片来源:沈虹

另外一类工人就是所谓的AI训练者,也就是我们所熟知的“数据标注工”。上图中,AI如何区分一张图究竟是吉娃娃还是蓝莓麦芬?这些工作对人工智能并不容易,但人类通过直觉或简单训练就可以区分。数据标注工负责对大量的图像、文本、语音识别进行归类、整理、纠错和标注。之后,机器学习算法会将人类标注过的数据作为数据训练集从中搜索规律。

AI公司通常将这批工作外包到劳动力报酬较低的地区,以节省成本。BBC曾报道,非洲肯尼亚的单亲妈妈如何帮助高大上的自动驾驶企业进行识别,通常这些企业会把图片发给非洲肯尼亚的单亲妈妈,让他们标注天气、物体、建筑等等。

从更广义的角度来说,AI背后更大的劳工是作为用户的我们。1950年代,著名传媒学者Dallas Smythe曾批评商业媒介——广播电视媒介生产的真正产品不是五花八门的各类节目,而是观众的注意力本身。因为商业媒体的内在逻辑是把用户的注意力打包卖给广告商,也就是著名的受众商品理论。在AI时代,作为用户的我们,免费为各种算法系统贡献着自己的时间、精力、数据、隐私以及劳动。

有时这些劳动如此微小,常常被我们忽视。比如苹果手机的来电留言,语音转化文字的功能,在转化完成之后,下面会有一团灰色的小字,询问用户转化是否有效。在我们对这些转化文字进行评价的时候,我们也在进一步为算法系统提供实时的人工反馈。

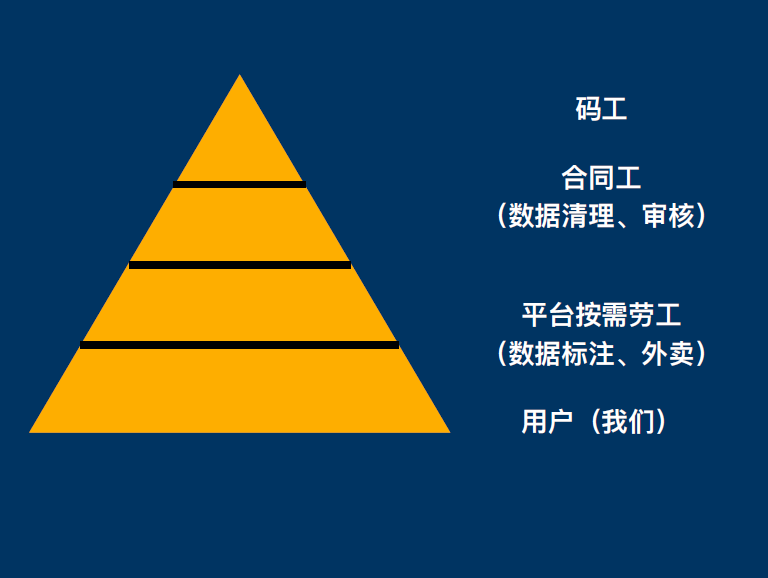

AI系统劳工金字塔。图片来源:沈虹

将AI的人工智能系统分解之后,我们会发现,所谓的高科技劳工“码工”只是AI系统当中非常小的一部分,AI劳工系统呈现着典型的金字塔型,最上层是少数的高科技、高工资的码农,虽然他们也有996的困难,但大体上有正式的社保和令人羡慕的工资。

第二层则是工资较低的合同工,比如内容审核员。他们承担一部分不那么关键的工作,但是工作非常不稳定,有随时被解雇的危险。第三层是数以万计的平台按需劳工,比如外卖小哥,他们承担着AI系统里最繁重、重复性最高、工资最低,也是最容易被取代的工作。

最后一层就是数量更为巨大的用户们,也就是我们,我们免费为各种人工智能系统贡献自己的时间、精力、数据,和种种不自知的劳动。

2018年,国际劳工组织ILO发表了一份针对75个国家3500名平台众包劳工的大规模调研报告。

调研指出,全世界大批平台劳工的薪资低于最低工资水平。2015年,他们的平均工资只有4.26美元,2017年下降到了3.31美元,远低于当时美国最低工资7.25美元。这些工人通常没有任何福利保障或升职渠道,他们工作的目的就是以大量的人力训练计算机算法,直到某一天算法不再需要他们。他们不仅没有和平台讨价还价的能力,还会被要求做一些不道德的工作,比如说为平台撰写假评论。

令人惊奇的是,该报告发现许多平台劳工受过良好的教育,37%有大学学位,20%甚至是研究生学历,其中32%的人将平台工作作为主要的收入渠道。从这个角度来看,人工智能并不会取代(replace)人类的工作,它只会重置(displace)人类的工作。

技术是中立的吗?

所以,我们也来到了今天的最后一个话题,也是科技社会学里一个非常非常经典的问题:技术是中立的吗?

每年,计算机专业的学生都会说:我们是做技术的,而技术是中立的,我们只管制造技术,我们控制不了技术会被怎样使用。每年AI社会学的最后一节课,我都会请学生重读一篇1980年代的经典之作,社会学家兰登·温纳(Langdon Winner)的“技术物有政治吗?”(Do Artifacts Have Politics?)。

当时身处科技重镇麻省理工大学的温纳力排众议,深刻探讨科技和社会之间的复杂互动。他认为科技产物当然有政治性,而过去政治哲学的讨论里大大低估了科技的重要性,但这样的政治性并非单项度的科技影响社会或者社会影响科技,科技在与社会的复杂互动里深层进化,并且深刻嵌入并塑造了当时的历史社会和权力关系。

温纳举了一个非常有名的例子,纽约长岛的“低架桥”,它们的高度被刻意压低,公共交通无法通过。为什么?因为当时低架桥横跨的马路通往纽约郊区的海滩,是中产阶级白人的休闲圣地。低架桥建得很低,能够阻隔那些只搭得起公交车的黑人和穷人。换句话说,即使中产阶级的海滩并没有“穷人和黑人禁止入内”的牌子,低架桥的设计事实上把穷人和黑人阻隔在了海滩之外,这延续并且制造了某种特定的社会权力关系。

温纳的另一个例子是1950年代由加州大学研究员在当地开发并且推广的番茄收割机,相比手动的番茄收割机,机器收割可以大大的提高效率。虽然它得到了推广,这一新兴的技术却没有使当地的居民平等享受技术收益,缺少有效的社会化反思,也没有合适的政策约束。

昂贵的机器虽然提高了生产率和生产效率,却促使了番茄种植园的工业化和集中化,大大减少了当地小农种植者和手工收割者的工作岗位,致使无数劳动者流离失所。这看上去微不足道的小小的机器,最终以一种令人惊讶的方式彻底重构了当地的社会和经济关系。所以技术是中立的吗?

更近的例子是网约车平台优步Uber。在美国,由于网约车平台和员工之间没有正式的雇佣关系,所以平台无法强制员工在某个时刻上班,或一定要达成某项任务。

为了尽可能将司机留在路上,优步雇佣了大批的心理学家和数据科学家,运用了复杂的算法,设计了一系列的心理学把戏。例如,优步系统里,新手司机有“第一个25单”的里程碑,新手们跑到10单左右时,系统会自动弹出消息“恭喜你,你快到一半了”。

值得注意的是,25绝不是一个随机数字,优步旗下的大批数学家经过海量数据分析发现,25单之后,司机留在平台继续工作的可能性大大增加。心理学家发现对人们设定具体的目标,更容易激励他们完成任务。

当司机想要下线休息,试图关闭手机上的派单系统,这个时候优步系统会突然跳这样一条消息:“距离赚满40元还差6元,你确定现在下线吗?”这里,“继续驾驶”被高亮成了蓝色,而“下线”被低暗成灰色,司机更可能选择继续驾驶,为优步继续贡献他们的劳动力。所以,在这里,技术和设计是中立的吗?

最后一个例子是2018年亚马逊在美国递交的一系列专利申请。亚马逊的工程师设计了一种给员工佩戴的智能手环,主要对象是仓库员工,会发射超音波脉冲和无线电传输,系统的感应器会测量信号,确定员工所处位置。

手环专利的通过引发了大批媒体的担忧,比如《纽约时报》,他们指出任何可穿戴设备都可以在员工无意识的情况下收集大量个人信息,包括员工的一举一动——什么时候去洗手间,什么时候会放慢速度,一天中什么时候会停下来休息,甚至停下来休息的频率。

人们常说,“打工人”抵抗算法系统的法宝之一是“带薪上厕所”,一旦亚马逊的手环付诸实践,打工人上厕所的时间也会被精确计算。在这里,这个手环是中立的吗?

最后这张图,来自我个人非常喜欢赛博朋克的电影《银翼杀手》,它描述的未来社会是光鲜亮丽的现代科技和破破烂烂人类生活。当人类社会进化到这样一种程度,有这么多、这么新的高科技,我们可以探索太空,为什么大部分人的生活还是这么破破烂烂的?也许这并不是一种艺术创造,而是一种单方面鼓励某种科技发展的结果。当人类社会将所有的人力、物力和自然资源倾注在某些科技的发展之上,其他方面的牺牲或许是无可避免的。说到底,资源是有限的。

今天,每个人都应该问自己这样一个问题,作为人类,我们真的需要永不间断的个性化新闻、早十分钟抵达楼下的外卖、每年都在更新换代的新手机吗?也许,作为社会学者,我们的责任就是在此时此刻,在人工智能算法狂飙突进的今天发问,人类需要的到底是什么?需要发展的科技到底是怎样的?

最后,我还会告诉学生,科技当然不是中立的,而且作为未来科技的设计者,你所站立的方向就是科技未来的方向。

最后的最后,还有一个彩蛋。每年,在学生画完他们心中的人工智能的算法之后,我也会告诉他们,我个人最喜欢的定义。这个定义来自于斯坦福大学著名的华裔女科学家李飞飞。在一次采访里,她引用了70年代的名言,指出今天人工智能系统的不足。李飞飞说:“现今意义上的人工智能,是个在身处的屋子着火时,却只知道完美下着国际象棋的机器。”

一个对着火的屋子不屑一顾的AI不是我们想要的AI,即使它可以下出世界上最完美的象棋。